Die Verbreiter von Corona-Panik sind möglicherweise Bots

Inhalt - Contents

Meet ‘Sara’, ‘Sharon’ and ‚Mel‘: why people spreading coronavirus anxiety on Twitter might actually be bots

Ryan Ko, The University of Queensland

Recently Facebook, Reddit, Google, LinkedIn, Microsoft, Twitter and YouTube committed to removing coronavirus-related misinformation from their platforms.

COVID-19 is being described as the first major pandemic of the social media age. In troubling times, social media helps distribute vital knowledge to the masses.

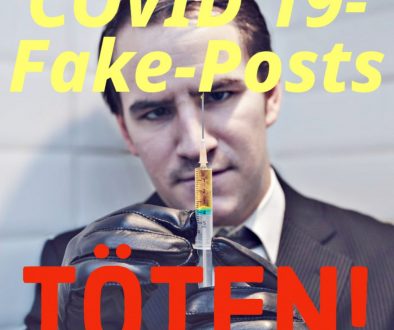

Unfortunately, this comes with myriad misinformation, much of which is spread through social media bots.

These fake accounts are common on Twitter, Facebook, and Instagram. They have one goal: to spread fear and fake news.

We witnessed this in the 2016 United States presidential elections, with arson rumours in the bushfire crisis, and we’re seeing it again in relation to the coronavirus pandemic.

Read more:

Bushfires, bots and arson claims: Australia flung in the global disinformation spotlight

Busy busting bots

Bot Sentinel

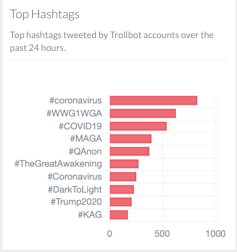

The exact scale of misinformation is difficult to measure. But its global presence can be felt through snapshots of Twitter bot involvement in COVID-19-related hashtag activity.

Bot Sentinel is a website that uses machine learning to identify potential Twitter bots, using a score and rating. According to the site, on March 26 bot accounts were responsible for 828 counts of #coronavirus, 544 counts of #COVID19 and 255 counts of #Coronavirus hashtags within 24 hours.

These hashtags respectively took the 1st, 3rd and 7th positions of all top-trolled Twitter hashtags.

It’s important to note the actual number of coronavirus-related bot tweets are likely much higher, as Bot Sentinel only recognises hashtag terms (such as #coronavirus), and wouldn’t pick up on “coronavirus”, “COVID19” or “Coronavirus”.

How are bots created?

Bots are usually managed by automated programs called bot “campaigns”, and these are controlled by human users. The actual process of creating such a campaign is relatively simple. There are several websites that teach people how to do this for “marketing” purposes. In the underground hacker economy on the dark web, such services are available for hire.

While it’s difficult to attribute bots to the humans controlling them, the purpose of bot campaigns is obvious: create social disorder by spreading misinformation. This can increase public anxiety, frustration and anger against authorities in certain situations.

A 2019 report published by researchers from the Oxford Internet Institute revealed a worrying trend in organised “social media manipulation by governments and political parties”. They reported:

Evidence of organised social media manipulation campaigns which have taken place in 70 countries, up from 48 countries in 2018 and 28 countries in 2017. In each country, there is at least one political party or government agency using social media to shape public attitudes domestically.

The modus operandi of bots

Typically, in the context of COVID-19 messages, bots would spread misinformation through two main techniques.

The first involves content creation, wherein bots start new posts with pictures that validate or mirror existing worldwide trends. Examples include pictures of shopping baskets filled with food, or hoarders emptying supermarket shelves. This generates anxiety and confirms what people are reading from other sources.

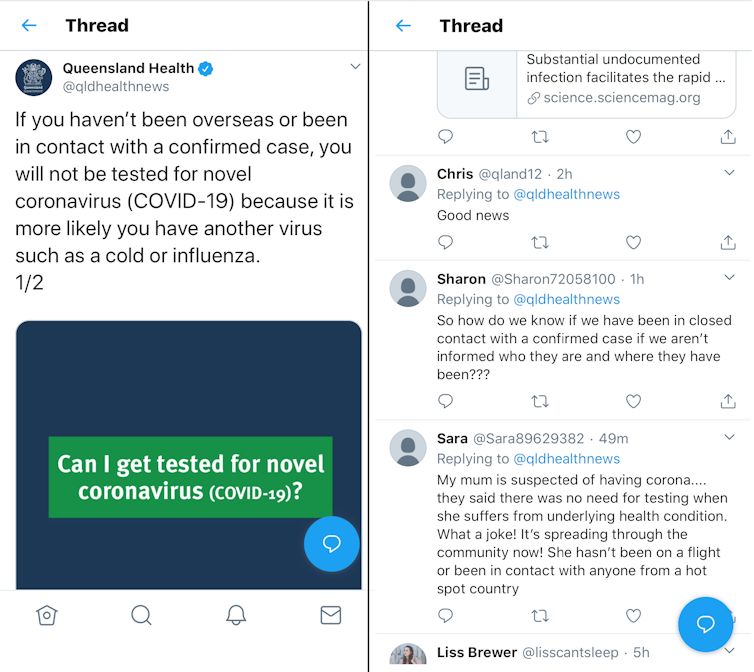

The second technique involves content augmentation. In this, bots latch onto official government feeds and news sites to sow discord. They retweet alarming tweets or add false comments and information in a bid to stoke fear and anger among users. It’s common to see bots talking about a “frustrating event”, or some social injustice faced by their “loved ones”.

The example below shows a Twitter post from Queensland Health’s official twitter page, followed by comments from accounts named “Sharon” and “Sara” which I have identified as bot accounts. Many real users reading Sara’s post would undoubtedly feel a sense of injustice on behalf of her “mum”.

While we can’t be 100% certain these are bot accounts, many factors point to this very likely being the case. Our ability to accurately identify bots will get better as machine learning algorithms in programs such as Bot Sentinel improve.

How to spot a bot

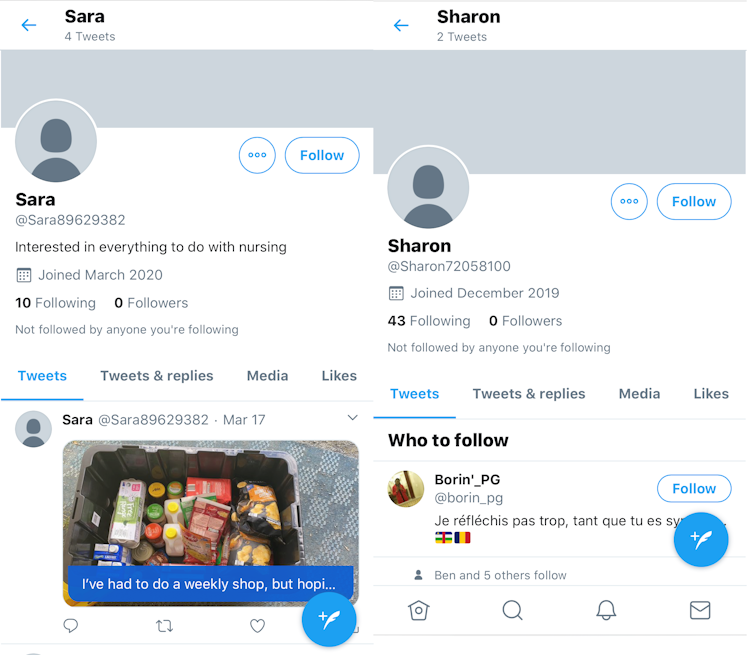

To learn the characteristics of a bot, let’s take a closer look Sharon’s and Sara’s accounts.

Both profiles lack human uniqueness, and display some telltale signs they may be bots:

- they have no followers

- they only recently joined Twitter

- they have no last names, and have alphanumeric handles (such as Sara89629382)

- they have only tweeted a few times

- their posts have one theme: spreading alarmist comments

- they mostly follow news sites, government authorities, or human users who are highly influential in a certain subject (in this case, virology and medicine).

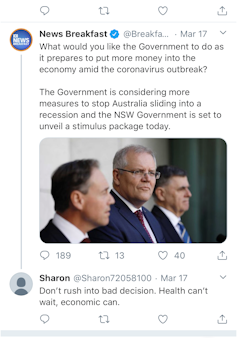

My investigation into Sharon revealed the bot had attempted to exacerbate anger on a news article about the federal government’s coronavirus response.

The language: “Health can’t wait. Economic (sic) can” indicates a potentially non-native English speaker.

It seems Sharon was trying to stoke the flames of public anger by calling out “bad decisions”.

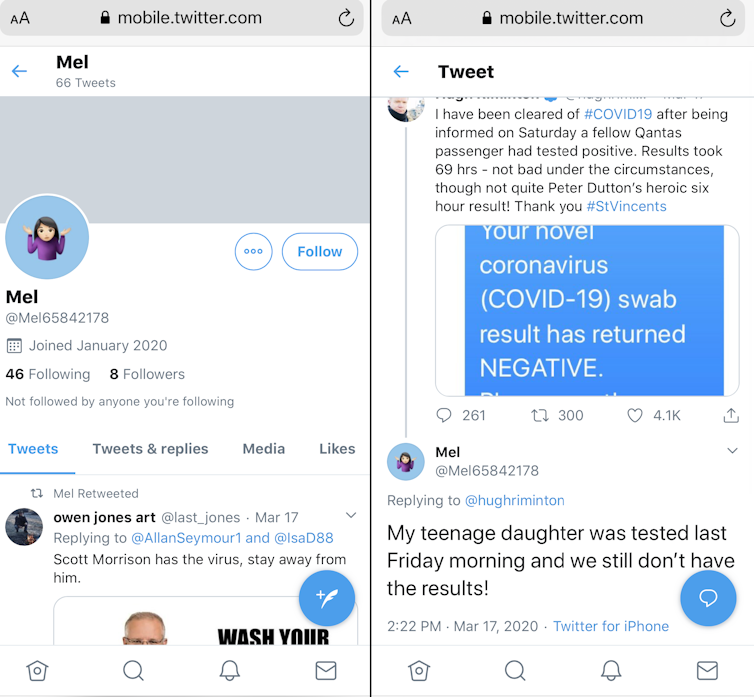

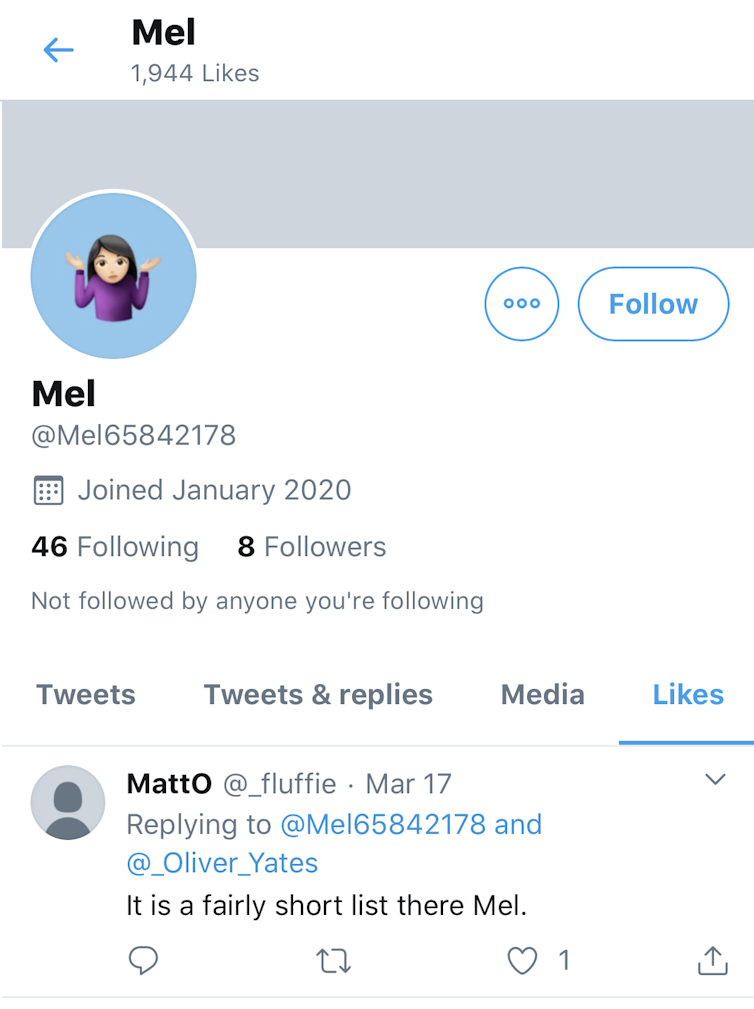

Looking through Sharon’s tweets, I discovered Sharon’s friend “Mel”, another bot with its own programmed agenda.

What was concerning was that a human user was engaging with Mel.

You can help tackle misinformation

Currently, it’s simply too hard to attribute the true source of bot-driven misinformation campaigns. This can only be achieved with the full cooperation of social media companies.

The motives of a bot campaign can range from creating mischief to exercising geopolitical control. And some researchers still can’t agree on what exactly constitutes a “bot”.

But one thing is for sure: Australia needs to develop legislation and mechanisms to detect and stop these automated culprits. Organisations running legitimate social media campaigns should dedicate time to using a bot detection tool to weed out and report fake accounts.

And as a social media user in the age of the coronavirus, you can also help by reporting suspicious accounts. The last thing we need is malicious parties making an already worrying crisis worse.

Read more:

You can join the effort to expose Twitter bots

![]()

Ryan Ko, Chair Professor and Director of Cyber Security, The University of Queensland

This article is republished from The Conversation under a Creative Commons license. Read the original article.

Übersetzung

Treffen Sie ‚Sara‘, ‚Sharon‘ und ‚Mel‘: Warum Menschen, die Coronavirus-Angst auf Twitter verbreiten, eigentlich Bots sein könnten

Geschrieben von:

Ryan Ko, Die Universität von Queensland

Kürzlich verpflichteten sich Facebook, Reddit, Google, LinkedIn, Microsoft, Twitter und YouTube, Coronavirus-bezogene Fehlinformationen von ihren Plattformen zu entfernen.

COVID-19 wird als die erste große Pandemie des Social-Media-Zeitalters beschrieben. In unruhigen Zeiten tragen soziale Medien dazu bei, lebenswichtiges Wissen an die Massen zu verbreiten.

Leider geht dies mit unzähligen Fehlinformationen einher, von denen ein Großteil über Social-Media-Bots verbreitet wird.

Diese gefälschten Accounts sind auf Twitter, Facebook und Instagram weit verbreitet. Sie haben ein Ziel: Angst und gefälschte Nachrichten zu verbreiten.

Wir haben dies bei den Präsidentschaftswahlen 2016 in den Vereinigten Staaten erlebt, mit Gerüchten über Brandstiftung in der Buschfeuerkrise, und wir sehen es wieder im Zusammenhang mit der Coronavirus-Pandemie.

Das genaue Ausmaß der Fehlinformationen ist schwer zu messen. Seine globale Präsenz ist jedoch anhand von Momentaufnahmen der Beteiligung von Twitter-Bots an Hashtag-Aktivitäten im Zusammenhang mit COVID-19 zu erkennen.

Bot Sentinel ist eine Website, die Maschinenlernen einsetzt, um potenzielle Twitter-Bots anhand einer Punktzahl und Bewertung zu identifizieren. Der Website zufolge waren Bot-Accounts am 26. März innerhalb von 24 Stunden für 828 Zählungen von #coronavirus, 544 Zählungen von #COVID19 und 255 Zählungen von #Coronavirus-Hashtags verantwortlich.

Diese Hashtags belegten jeweils den 1., 3. und 7. Platz aller Twitter-Hashtags mit der höchsten Zählrate.

Es ist wichtig zu beachten, dass die tatsächliche Anzahl von Bot-Tweets im Zusammenhang mit Coronavirus wahrscheinlich viel höher ist, da Bot Sentinel nur Hashtag-Begriffe (wie #coronavirus) erkennt und „Coronavirus“, „COVID19“ oder „Coronavirus“ nicht erfassen würde.

Wie werden Bots erzeugt?

Bots werden üblicherweise von automatisierten Programmen namens Bot-„Kampagnen“ verwaltet, und diese werden von menschlichen Benutzern kontrolliert. Der eigentliche Prozess der Erstellung einer solchen Kampagne ist relativ einfach. Es gibt mehrere Websites, auf denen die Leute lernen, wie man dies zu „Marketing“-Zwecken macht. In der Untergrundhacker-Ökonomie des Dark Web können solche Dienste gemietet werden.

Es ist zwar schwierig, Bots den Personen zuzuordnen, die sie kontrollieren, aber der Zweck von Bot-Kampagnen liegt auf der Hand: durch die Verbreitung von Fehlinformationen soziale Unordnung zu schaffen. Dies kann in bestimmten Situationen die Ängste der Öffentlichkeit, die Frustration und den Ärger gegen Behörden verstärken.

Ein 2019 von Forschern des Oxford Internet Institute veröffentlichter Bericht enthüllte einen beunruhigenden Trend bei der organisierten „Manipulation von sozialen Medien durch Regierungen und politische Parteien“. Sie berichteten:

Es gibt Beweise für organisierte Kampagnen zur Manipulation sozialer Medien, die in 70 Ländern stattgefunden haben, gegenüber 48 Ländern im Jahr 2018 und 28 Ländern im Jahr 2017. In jedem Land gibt es mindestens eine politische Partei oder Regierungsbehörde, die soziale Medien nutzt, um die Einstellung der Öffentlichkeit im eigenen Land zu beeinflussen.

Die Arbeitsweise von Bots

Normalerweise würden Bots im Zusammenhang mit COVID-19-Nachrichten Fehlinformationen über zwei Haupttechniken verbreiten.

Die erste beinhaltet die Erstellung von Inhalten, wobei Bots neue Beiträge mit Bildern beginnen, die bestehende weltweite Trends bestätigen oder spiegeln. Beispiele hierfür sind Bilder von Einkaufskörben, die mit Lebensmitteln gefüllt sind, oder Hamsterer, die Supermarktregale leeren. Dies erzeugt Ängste und bestätigt, was Menschen aus anderen Quellen lesen.

Die zweite Technik beinhaltet eine inhaltliche Erweiterung. Dabei greifen Bots auf offizielle Regierungs-Feeds und Nachrichten-Websites zu, um Zwietracht zu säen. Sie twittern alarmierende Tweets oder fügen falsche Kommentare und Informationen hinzu, um Angst und Ärger unter den Nutzern zu schüren. Es kommt häufig vor, dass Bots über ein „frustrierendes Ereignis“ sprechen oder über soziale Ungerechtigkeiten, denen ihre „Lieben“ ausgesetzt sind.

Das folgende Beispiel zeigt einen Twitter-Post von der offiziellen Twitter-Seite von Queensland Health, gefolgt von Kommentaren von Konten mit den Namen „Sharon“ und „Sara“, die ich als Bot-Konten identifiziert habe. Viele echte Benutzer, die Saras Post lesen, würden zweifellos ein Gefühl der Ungerechtigkeit im Namen ihrer „Mama“ empfinden.

Wir können zwar nicht hundertprozentig sicher sein, dass es sich um Bot-Accounts handelt, aber viele Faktoren deuten darauf hin, dass dies sehr wahrscheinlich der Fall ist. Unsere Fähigkeit, Bots genau zu identifizieren, wird sich in dem Maße verbessern, wie sich die Algorithmen des maschinellen Lernens in Programmen wie Bot Sentinel verbessern.

Wie man einen Bot erkennt

Um die Merkmale eines Bot zu erfahren, wollen wir uns die Berichte von Sharon und Sara genauer ansehen.

Beiden Profilen mangelt es an menschlicher Individualität, und sie weisen einige verräterische Anzeichen auf, dass es sich um Bots handeln könnte:

- sie haben keine Follower

- sie sind erst kürzlich Twitter beigetreten

- sie haben keine Nachnamen und haben alphanumerische Handles (wie z.B. Sara89629382)

- sie haben nur ein paar Mal getwittert

- ihre Beiträge haben ein Thema: Verbreitung alarmierender Kommentare

Bot ‚Sharon‘ versuchte, andere durch ihre Tweets zu verärgern.

Sie verfolgen meist Nachrichtenseiten, Regierungsbehörden oder menschliche Benutzer, die in einem bestimmten Fachgebiet (in diesem Fall Virologie und Medizin) sehr einflussreich sind.

Meine Untersuchung von Sharon ergab, dass der Bot versucht hatte, die Wut auf einen Nachrichtenartikel über die Bundesregierung zu schüren.

Die Sprache: “Health can’t wait. Economic (sic) can” deutet auf einen potentiellen Nicht-Muttersprachler der englischen Sprache hin.

Es scheint, dass Sharon versuchte, die Flammen des öffentlichen Ärgers zu schüren, indem sie „schlechte Entscheidungen“ anprangerte.

Es scheint, dass Sharon versuchte, die Flammen des öffentlichen Ärgers zu schüren, indem sie „schlechte Entscheidungen“ rief.

Als ich Sharons Tweets durchsah, entdeckte ich Sharons Freund „Mel“, einen weiteren Bot mit einer eigenen programmierten Agenda.

Bot „Mel“ verbreitete falsche Informationen über eine mögliche Verzögerung der COVID-19-Ergebnisse und twitterte hasserfüllte Nachrichten zurück.

Besorgniserregend war, dass sich ein menschlicher Benutzer mit Mel beschäftigte. Ein Account, der einem echten Twitter-Benutzer zu gehören schien, begann, sich mit ‚Mel‘ zu beschäftigen.

Sie können bei der Bekämpfung von Fehlinformationen helfen

Gegenwärtig ist es einfach zu schwierig, die wahre Quelle für Bot-getriebene Fehlinformationskampagnen zuzuordnen. Dies kann nur mit der vollen Kooperation von Social-Media-Unternehmen erreicht werden.

Die Motive einer Bot-Kampagne können von Unheil stiften bis hin zur Ausübung geopolitischer Kontrolle reichen. Und einige Forscher können sich immer noch nicht darüber einigen, was genau ein „Bot“ ist.

Aber eines ist sicher: Australien muss Gesetze und Mechanismen entwickeln, um diese automatisierten Täter aufzuspüren und zu stoppen. Organisationen, die legitime Kampagnen in den sozialen Medien durchführen, sollten Zeit dafür aufwenden, ein Bot-Erkennungsinstrument einzusetzen, um gefälschte Konten auszusortieren und zu melden.

Und als Nutzer sozialer Medien im Zeitalter des Coronavirus können Sie auch helfen, indem Sie verdächtige Konten melden. Das Letzte, was wir brauchen, sind böswillige Parteien, die eine bereits besorgniserregende Krise noch verschlimmern.

The Conversation

Ryan Ko, Vorsitzender Professor und Direktor für Cybersicherheit, Universität Queensland

Zum Original-Beitrag

Dieser Artikel wird aus The Conversation unter einer Creative-Commons-Lizenz wiederveröffentlicht. Lesen Sie den Originalartikel.